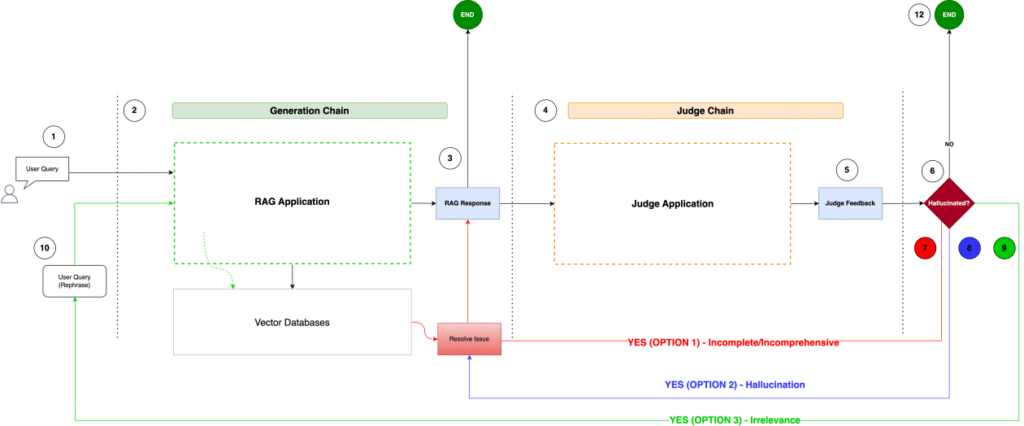

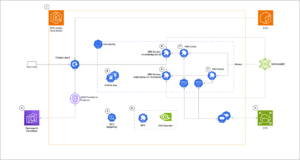

Las aplicaciones de inteligencia artificial generativa están transformando drásticamente el panorama empresarial al mejorar la productividad a través de asistentes digitales. Estos sistemas utilizan sofisticadas arquitecturas backend, tales como Generación Aumentada por Recuperación (RAG), flujos de trabajo agentivos y modelos de lenguaje de gran escala (LLMs), o incluso una combinación de estas tecnologías para funcionar de manera eficiente. Sin embargo, el desarrollo y la implementación de asistentes de IA confiables dependen de una base sólida de datos verídicos y un riguroso marco de evaluación.

Los datos de referencia en inteligencia artificial son cruciales, pues constituyen el estándar factual contra el cual se evalúa el rendimiento de los asistentes. Al establecer un punto de comparación esperado, los datos verídicos permiten una evaluación determinística, esencial para medir la calidad del sistema de IA generativa. Esta comparación facilita la creación de referencias personalizadas, cruciales para monitorear el rendimiento y para analizar estadísticamente múltiples asistentes que realizan la misma tarea. Además, cuantificar el rendimiento en función de mejoras realizadas es posible dentro de un entorno controlado gracias a esas referencias.

El proceso de evaluación determinística, utilizando métricas como el Conocimiento Factual y la Precisión QA de FMEval, está estrechamente vinculado a la generación de datos verídicos. Una implementación adecuada de la métrica de evaluación debe guiar la creación de estos datos para asegurar una medición precisa de la aplicación de respuesta a preguntas.

El artículo también expone las mejores prácticas para utilizar modelos de lenguaje de gran escala en la generación y evaluación de datos verídicos cuando se emplea FMEval en un entorno corporativo. FMEval, una suite de evaluación integral de Amazon SageMaker Clarify, ofrece métricas estandarizadas para evaluar la calidad y la responsabilidad de los asistentes de IA.

Para implementar de manera efectiva datos verídicos de alta fidelidad, se recomienda empezar con la curación humana de un conjunto pequeño de datos de preguntas y respuestas. Este conjunto debe ser significativo y preparado por expertos en el tema para asegurar un alineamiento de datos desde el inicio, generando discusiones importantes sobre qué preguntas son valiosas para la empresa a lo largo del tiempo.

Para escalar el proceso de generación y curación de datos verídicos, es recomendable utilizar una estrategia de prompts con LLMs combinada con un enfoque basado en riesgos. Sin embargo, la participación de expertos es insustituible para asegurar que las preguntas fundamentales del negocio se traduzcan en datos verídicos valiosos.

La generación de los datos debe realizarse mediante la representación mínima de la respuesta verídica, asegurando que las métricas de evaluación sean coherentes con las expectativas y estándares de la empresa. Este enfoque permite evaluar de manera efectiva la calidad y responsabilidad de los asistentes utilizando FMEval.

En resumen, esta metodología proporciona un camino claro para las organizaciones que busquen desarrollar y evaluar asistentes de inteligencia artificial generativa, asegurando que cuenten con la información y estándares necesarios para mantenerse competitivos en un mercado en rápida evolución.