La inteligencia artificial (IA) se ha posicionado como el motor impulsor de la revolución digital en el siglo XXI, desempeñando un papel crucial en las aplicaciones de visión por computadora. En este contexto, el manejo eficaz de grandes volúmenes de datos y el desarrollo de pipelines de datos eficientes son esenciales para garantizar un entrenamiento óptimo de los modelos de IA. En particular, los modelos de aprendizaje profundo requieren ingentes cantidades de datos de imágenes etiquetadas para alcanzar niveles efectivos de aprendizaje y razonamiento. De ahí la importancia de contar con pipelines de procesamiento de imágenes bien estructurados y escalables, que aseguren un entrenamiento con datos de alta calidad, minimizando errores y optimizando el rendimiento general del modelo.

Las aplicaciones de IA que dependen de imágenes son conocidas por su insaciable demanda de datos, ya que tareas como la clasificación de imágenes, la detección de objetos o el reconocimiento facial precisan millones de imágenes para ser eficaces. Antes de su uso en el entrenamiento, estas imágenes necesitan ser sometidas a un preprocesamiento que puede incluir tareas como el cambio de tamaño, la normalización y, frecuentemente, la augmentación de datos. A medida que el volumen de datos incrementa, las operaciones de preprocesamiento se tornan más complejas, haciendo indispensable un sistema en Python que sea flexible y robusto y que pueda gestionar tareas diversas, como la rápida ingesta de datos, el almacenamiento accesible, la escalabilidad y la automatización de procesos, junto con un monitoreo constante para anticipar problemas potenciales.

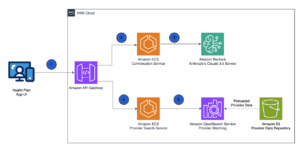

El proceso de ingesta de datos es el primer paso en el pipeline, recopilando imágenes de diferentes fuentes como repositorios públicos, bases de datos empresariales o mediante scraping web. Dada la magnitud de los conjuntos de datos, que pueden ir desde miles hasta millones de archivos, es imperativo diseñar mecanismos eficientes para gestionar esta ingesta, como el procesamiento en lotes y la ingesta en tiempo real desde cámaras o dispositivos IoT. Además, el versionado de los conjuntos de datos asegura su integridad y trazabilidad durante todo el proceso de entrenamiento.

Una vez que las imágenes son captadas, requieren un preprocesamiento riguroso para asegurar que estén listas para la formación de modelos. La eficiencia del preprocesamiento puede potenciarse mediante la paralelización del procesamiento, el uso de unidades de procesamiento gráfico (GPU) para manejar tareas intensivas como la augmentación, y la automatización del pipeline con herramientas populares como TensorFlow o PyTorch.

La gestión y almacenamiento de datos es otro componente crítico. Es recomendable utilizar sistemas de almacenamiento distribuidos como Amazon S3 o Google Cloud Storage, que facilitan no solo una alta disponibilidad, sino también la gestión de grandes volúmenes de datos sin complicar la infraestructura subyacente. Es vital que el almacenamiento soporte un acceso rápido durante las fases de entrenamiento, contemple mecanismos de caché para imágenes de acceso frecuente, y emplee compresión para disminuir costos de almacenamiento y tiempos de transferencia de imágenes.

Además, la escalabilidad y el procesamiento distribuido son esenciales. La habilidad de escalar las operaciones conforme los conjuntos de datos crecen es fundamental. Herramientas como Apache Spark o Dask permiten el procesamiento paralelo en múltiples máquinas, lo cual ahorra tiempo y aumenta la eficiencia. Las estrategias de escalado horizontal y la adopción de arquitecturas serverless proporcionan la flexibilidad necesaria para manejar el procesamiento de imágenes.

Finalmente, es crucial llevar a cabo un monitoreo continuo del pipeline. Herramientas como Prometheus o Grafana facilitan la supervisión de métricas de rendimiento, mientras que las estrategias de automatización y mantenimiento aseguran que todos los procesos, desde la ingesta hasta la detección de errores, operen de manera eficiente y efectiva. La implementación de adecuadas prácticas de gobernanza de datos garantizará además la seguridad y coherencia de los conjuntos de datos.

En resumen, el desarrollo y mantenimiento de pipelines escalables de procesamiento de datos de imagen para la formación de IA requiere una meticulosa planificación en cada etapa del proceso, desde la ingesta y preprocesamiento hasta el almacenamiento y la automatización. La combinación de procesamiento distribuido, soluciones basadas en la nube y tecnología de automatización posibilitan la creación de pipelines eficientes y ágiles que pueden enfrentar el creciente volumen de datos, estableciendo una base sólida para modelos de IA robustos y de alto rendimiento.