Los equipos dedicados a la ciencia de datos y la inteligencia artificial enfrentan un reto constante: la creciente complejidad de los modelos de aprendizaje automático. A pesar de que los Contenedores de Aprendizaje Profundo de Amazon (DLCs) proporcionan entornos optimizados, la personalización para proyectos específicos suele requerir experiencia técnica y tiempo significativo.

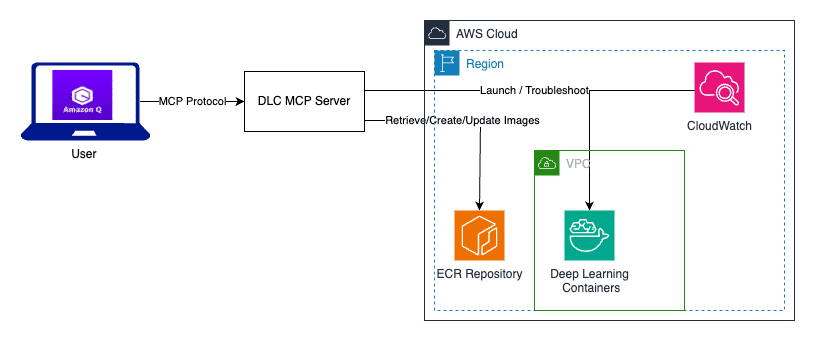

Para resolver este desafío, se ha presentado Amazon Q Developer junto con el Protocolo de Contexto de Modelo (MCP). Esta innovación busca optimizar los flujos de trabajo de los DLCs, automatizando la creación, ejecución y personalización de contenedores, simplificando el trabajo de los desarrolladores.

Los AWS DLCs son entornos preconfigurados que facilitan el entrenamiento y despliegue de modelos de lenguaje a gran escala en plataformas como Elastic Compute Cloud, Elastic Kubernetes Service y Elastic Container Service, sin costos adicionales. Mantener estos contenedores actualizados ayuda a evitar problemas como las incompatibilidades de versiones.

No obstante, personalizaciones adicionales, como la instalación de bibliotecas propietarias, pueden ser problemáticas. Tradicionalmente, esto requiere reconstrucción manual de contenedores y configuraciones extensas, lo que significa días de trabajo y riesgos de errores.

Amazon Q actúa como un asistente experto de AWS, proporcionando orientación en lenguaje natural. El Protocolo de Contexto de Modelo permite conectar los asistentes de IA a herramientas y servicios externos, ayudando en la configuración de los contenedores DLC.

El servidor DLC MCP facilita esta gestión mediante seis funciones clave, entre ellas, la gestión de contenedores, la creación de imágenes personalizadas y la implementación en servicios de computación de AWS. También ofrece servicios de diagnóstico para resolver problemas relacionados con DLCs.

La combinación de Amazon Q y el servidor DLC MCP ha demostrado mejorar la experiencia del usuario al reducir significativamente el tiempo de configuración y los errores, permitiendo a los equipos centrarse en desarrollar soluciones de IA y no en la infraestructura. Este enfoque también promueve una transición más fluida del desarrollo a la producción, incrementando la eficiencia y efectividad de los proyectos de inteligencia artificial.