La evolución continua del machine learning (ML) ha dejado atrás su fase experimental para convertirse en una herramienta crucial dentro de las operaciones comerciales modernas. En la actualidad, diversas organizaciones están usando modelos de ML para realizar pronósticos de ventas precisos, segmentar clientes de manera efectiva, y predecir la deserción de manera anticipada. Aunque los modelos de ML tradicionales siguen siendo clave en mejorar los procesos empresariales, la inteligencia artificial generativa ha surgido como una fuerza que transforma la interacción con el cliente mediante herramientas accesibles.

A pesar de esta nueva ola de inteligencia artificial generativa, las soluciones de ML convencionales son indispensables para ciertas tareas predictivas. Por ejemplo, los pronósticos de ventas, que dependen del análisis de datos históricos y tendencias, se gestionan mejor con algoritmos de ML establecidos como bosques aleatorios, máquinas de gradiente, modelos ARIMA, y redes LSTM. Modelos tradicionales como K-means y la segmentación jerárquica también son ideales para la segmentación de clientes y la predicción de deserción. Mientras que la inteligencia artificial generativa muestra habilidades únicas en la creación de contenido y el diseño de productos, los modelos de ML convencionales sobresalen en predicciones basadas en datos. La combinación de ambas estrategias puede resultar en soluciones que entreguen pronósticos precisos y mantengan la eficiencia de costos.

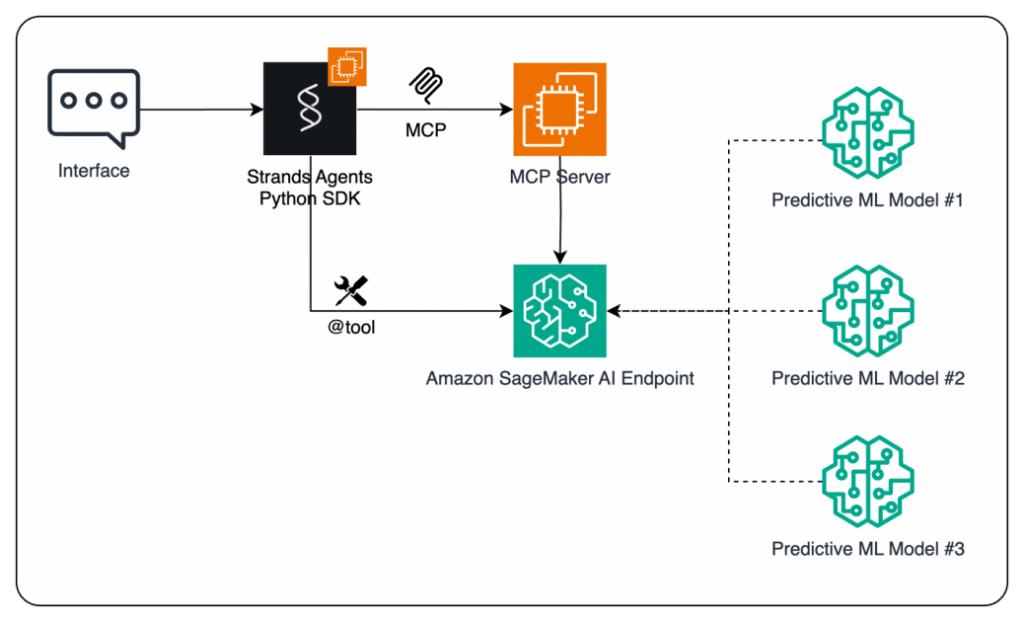

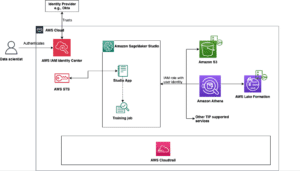

Para mostrar cómo las organizaciones pueden potenciar sus agentes de inteligencia artificial mediante la integración de modelos predictivos de ML, se desarrolló un flujo de trabajo que permite a estos agentes tomar decisiones informadas. Esta solución incorpora el Protocolo de Contexto de Modelo (MCP), un estándar abierto que facilita cómo las aplicaciones proporcionan contexto a los modelos de lenguaje grandes (LLMs) con la ayuda de Amazon SageMaker AI.

Los agentes de inteligencia artificial, utilizando el SDK de Strands Agents, emplean un LLM como su «cerebro» central, permitiéndoles observar su entorno, planificar acciones y ejecutar tareas con mínima intervención humana. Gracias a esta integración, los agentes pueden superar la simple generación de texto para convertirse en entidades autónomas que ejecutan acciones alineadas con metas específicas en diversos escenarios empresariales.

Para implementar esta solución, se entrena un modelo de pronóstico de series temporales usando Amazon SageMaker AI. A través de una cuidadosa preparación de datos y una ingeniosa ingeniería de características, un modelo como XGBoost se entrena para predecir la demanda futura basándose en patrones históricos. Posteriormente, este modelo se despliega en un endpoint de SageMaker AI, permitiendo accesos en tiempo real a través de llamadas API.

Una vez completado el proceso, las predicciones generadas son reenviadas al agente, permitiendo mejorar en la toma de decisiones y ejecutar acciones más informadas. Esta estructura no solo proporciona una base sólida para aplicaciones de inteligencia artificial, sino que también ofrece flexibilidad al permitir la elección entre acceso directo a endpoints y una integración basada en MCP, adaptándose así a variadas necesidades empresariales.

Las organizaciones siguen explorando formas de optimizar sus agentes de inteligencia artificial, y la combinación de herramientas como Amazon SageMaker AI, MCP, y el SDK de Strands Agents se presenta como una poderosa solución para crear aplicaciones de próxima generación.