Los asistentes conversacionales basados en la Generación Aumentada por Recuperación (RAG) están transformando significativamente el soporte al cliente y las búsquedas empresariales. Esta tecnología permite ofrecer respuestas rápidas y precisas, personalizadas con los datos de la empresa, sin la necesidad de ajustes complicados.

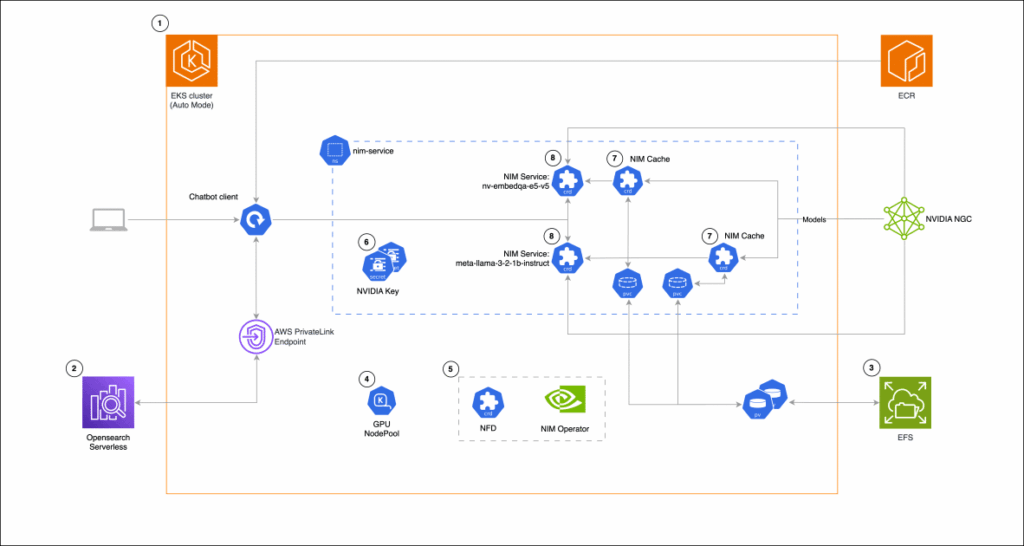

Amazon Elastic Kubernetes Service (EKS) es la plataforma preferida para operar estos asistentes debido a su flexibilidad y control total sobre los datos e infraestructura. Este servicio se adapta a diversas cargas de trabajo, garantizando una solución costo-efectiva y fácil de integrar en entornos Kubernetes, ya sea localmente o en la nube.

Los microservicios NVIDIA NIM simplifican la gestión e implementación de modelos de inteligencia artificial, integrándose de manera eficiente con servicios de Amazon como EC2, EKS y SageMaker. Distribuidos como contenedores Docker, estos microservicios eliminan la complejidad del manejo técnico y optimizan el despliegue de modelos de IA.

El operador NVIDIA NIM mejora la eficiencia en Kubernetes al gestionar coordinadamente recursos y reducir la latencia, facilitando así la escalabilidad automática. En una aplicación práctica, un asistente RAG utiliza NVIDIA NIM para la inferencia de modelos de lenguaje y Amazon OpenSearch Serverless para la gestión de datos, todo desplegado sobre la infraestructura de EKS.

El desarrollo de la solución abarca desde la configuración de EKS y OpenSearch Serverless, hasta la implementación de sistemas de archivo EFS y nodos GPU con Karpenter. Estos pasos aseguran un rendimiento óptimo y costos eficientes, integrando herramientas para una gestión sencilla de los modelos y garantizando respuestas precisas.

El sistema incluye un cliente basado en chat con bibliotecas como Gradio y LangChain, proporcionando una interfaz intuitiva. Este enfoque demuestra la eficacia de Amazon EKS para desplegar aplicaciones de inteligencia artificial con la fiabilidad y escalabilidad necesarias para las crecientes demandas empresariales.