La reciente evolución de la inteligencia artificial generativa ha introducido una nueva complejidad en el proceso de construcción, entrenamiento y despliegue de modelos de aprendizaje automático. Este desafío requiere un alto nivel de especialización, acceso a amplios conjuntos de datos y la gestión de grandes clústeres de computación. Asimismo, los clientes deben desarrollar código especializado para el entrenamiento distribuido, optimizar modelos de manera continua y enfrentar problemas de hardware, todo ello dentro de limitaciones de tiempo y presupuesto.

Con el propósito de simplificar estos retos, Amazon Web Services (AWS) ha lanzado Amazon SageMaker HyperPod. Esta herramienta promete transformar la manera en que las empresas desarrollan e implementan inteligencia artificial, como se subrayó en la conferencia AWS re:Invent 2023. Andy Jassy, CEO de Amazon, destacó que esta innovación acelera el entrenamiento de modelos de aprendizaje automático mediante la distribución y paralelización de las cargas de trabajo en numerosos procesadores avanzados, como los chips Trainium de AWS o GPUs. Además, HyperPod supervisa constantemente la infraestructura para detectar problemas, solucionándolos automáticamente y asegurando que el trabajo pueda continuar sin interrupciones.

Con el despliegue de nuevas características en AWS re:Invent 2024, SageMaker HyperPod está diseñado para abordar las demandas de las modernas cargas de trabajo en inteligencia artificial, ofreciendo clústeres persistentes y optimizados para el entrenamiento distribuido y la inferencia acelerada. Entre los usuarios de esta herramienta se encuentran desde startups innovadoras como Writer y Luma AI, hasta gigantes del sector como Thomson Reuters y Salesforce, que han logrado acelerar el desarrollo de modelos gracias a su implementación.

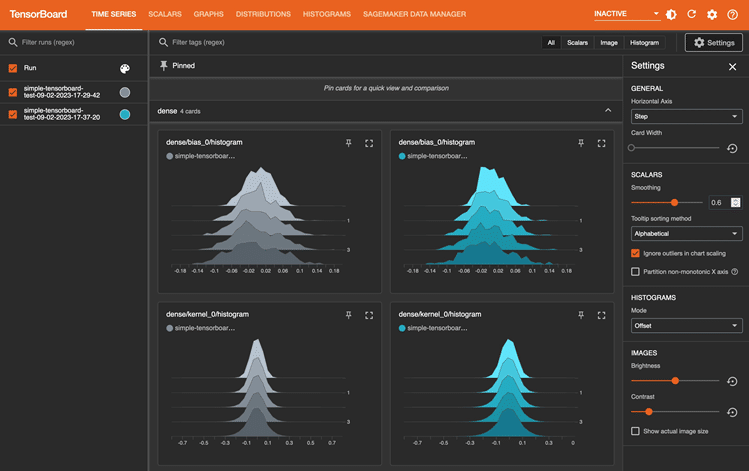

SageMaker HyperPod también ofrece un control profundo de la infraestructura, permitiendo conexiones seguras para entrenamientos avanzados y gestionando la infraestructura a través de Amazon EC2. Al mantener un grupo de instancias dedicadas y reservas, la herramienta minimiza el tiempo de inactividad crítico. Mediante herramientas de orquestación como Slurm y Amazon EKS, los desarrolladores pueden optimizar la gestión de trabajos y el uso de recursos.

Desde el punto de vista de la gestión de recursos, las organizaciones encuentran dificultades al tratar de gobernar el uso de gran capacidad de computación, esencial para el entrenamiento de modelos. SageMaker HyperPod permite maximizar la utilización de recursos, priorizando tareas cruciales y evitando la subutilización. Esto no solo reduce los costes de desarrollo de modelos hasta en un 40%, sino que alivia a los administradores de la constante redistribución de recursos.

La implementación de planes de entrenamiento flexibles dentro de SageMaker HyperPod ofrece a los clientes la posibilidad de definir fechas de finalización y la capacidad máxima de recursos necesarios, simplificando la adquisición de capacidad de computación y ahorrando semanas de preparación. Por ejemplo, Hippocratic AI, una empresa enfocada en el ámbito de la salud, ha empleado estos planes para acceder eficientemente a potentes instancias EC2 P5, facilitando así el desarrollo de su modelo de lenguaje principal.

En conclusión, SageMaker HyperPod representa un cambio paradigmático en la infraestructura de inteligencia artificial, centrado en una gestión de recursos inteligente y adaptativa, que permite a las organizaciones maximizar la eficiencia y reducir los costos. Con su enfoque en la integración de infraestructuras de entrenamiento e inferencia, este servicio promete optimizar el ciclo de vida de la inteligencia artificial desde el desarrollo hasta su implementación en el mundo real, desempeñando un papel crucial en la evolución continua del sector.