En la creciente era de la inteligencia artificial, las organizaciones están optando cada vez más por el uso de múltiples modelos de lenguaje grandes (LLM, por sus siglas en inglés) para el desarrollo de aplicaciones de IA generativa. Este enfoque, aunque desafiante, permite seleccionar el modelo adecuado según la tarea, adaptándose a diferentes dominios y optimizando costos, latencia y calidad. En esencia, dota a las aplicaciones de una robustez y versatilidad que les permite responder eficazmente a las diversas exigencias de los usuarios y objetivos comerciales específicos.

El desafío principal al implementar múltiples LLM es dirigir cada solicitud del usuario al modelo más apropiado. Esta tarea de enrutamiento requiere una lógica que interprete correctamente los mensajes, asignándolos a tareas predefinidas y dirigiéndolos al modelo correspondiente. Esto propicia que una sola aplicación gestione varios tipos de tareas, cada una con sus propias complejidades y dominios.

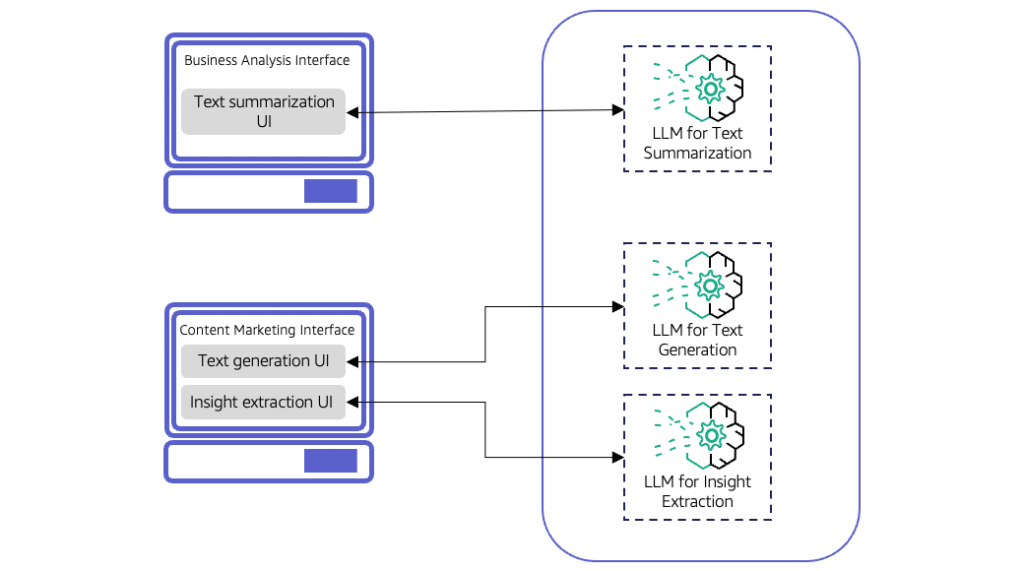

Varias aplicaciones pueden beneficiarse de este enfoque. Por ejemplo, una herramienta de creación de contenido de marketing podría necesitar generar texto, resumir documentos, analizar sentimientos o extraer información específica. A medida que estas aplicaciones se tornan más complejas, se vuelve crucial que manejen distintas complejidades de tareas dependiendo del nivel del usuario. Así, un asistente de IA para resumen de textos, por ejemplo, debe ser capaz de gestionar consultas simples y complejas de manera efectiva.

Para el enrutamiento de solicitudes existen dos enfoques principales: el estático y el dinámico. El enrutamiento estático es eficaz para aplicaciones con componentes de interfaz de usuario específicos para cada tarea. Aunque flexible, añadir nuevas tareas podría requerir el desarrollo de nuevos componentes. En cambio, el enrutamiento dinámico, que es común en asistentes virtuales y chatbots, utiliza un único componente de interfaz para interceptar solicitudes y dirigirlas al modelo más adecuado.

En el ámbito del enrutamiento dinámico destacan técnicas como el enrutamiento asistido por LLM, donde un modelo clasificador toma decisiones de enrutamiento. Aunque complejo, ofrece decisiones más precisas, a menudo a un costo mayor. Otra técnica es el enrutamiento semántico, que utiliza vectores numéricos para determinar similitudes con categorías de tareas predefinidas. Este enfoque es especialmente útil para aplicaciones que deben adaptarse constantemente a nuevas categorías.

Alternativamente, un enfoque híbrido, que combine enrutamientos estáticos y dinámicos, puede ofrecer una solución más robusta y adaptativa, aunque requiere un análisis cuidadoso de costos, latencia y complejidad de mantenimiento, junto con una evaluación constante del rendimiento de los modelos.

Las organizaciones están explorando plataformas como Amazon Bedrock, que proporciona un servicio gestionado de LLM y facilita el enrutamiento inteligente de solicitudes. Esta plataforma permite a los desarrolladores centrarse en la creación y desarrollo de aplicaciones mientras optimiza costos y calidad de las respuestas, potencialmente reduciendo los costos de operación hasta en un 30%.

En conclusión, el uso de múltiples LLM en aplicaciones de inteligencia artificial generativa no solo amplía las capacidades de las organizaciones, sino que mejora significativamente la experiencia del usuario. Sin embargo, el éxito de su implementación está sujeto a la cuidadosa consideración de sus dinámicas y necesidades específicas.