Los modelos de lenguaje de gran tamaño (LLMs) han avanzado rápidamente, convirtiéndose en componentes esenciales para aplicaciones que oscilan desde la inteligencia conversacional hasta el razonamiento complejo. No obstante, a medida que estos modelos aumentan en tamaño y capacidad, evaluarlos efectivamente se ha vuelto más complicado. Las métricas tradicionales, como la perplejidad y los puntajes BLEU, a menudo no logran captar las sutilezas de las interacciones en el mundo real, lo que hace crucial la implementación de marcos de evaluación alineados con humanos. Comprender cómo se evalúan los LLMs puede llevar a despliegues más fiables y a comparaciones justas entre diferentes modelos.

En este contexto, se han explorado métodos de evaluación automatizados y alineados con humanos que emplean LLMs como jueces. Este enfoque utiliza un LLM más potente para evaluar y clasificar las respuestas de otros modelos basándose en criterios predefinidos como corrección, coherencia, utilidad o profundidad del razonamiento. Esta estrategia es popular debido a su escalabilidad, consistencia y eficiencia en comparación con la evaluación por jueces humanos. El análisis revisa diferentes escenarios de evaluación usando LLMs como jueces, incluidos la comparación en pares y la evaluación de respuestas individuales.

Para proporcionar información concreta, se utilizan MT-Bench y Arena-Hard, dos marcos de evaluación ampliamente utilizados. MT-Bench ofrece un enfoque estructurado multivuelta adaptado a interacciones tipo chatbot, mientras que Arena-Hard se centra en clasificar los LLMs a través de batallas directas en tareas desafiantes. Ambos marcos buscan acercar la evaluación automatizada y la humana, asegurando que los LLMs no se evalúen solo mediante puntos de referencia sintéticos, sino también en casos de uso prácticos.

El estudio evaluó todos los modelos de la familia Amazon Nova, incluyendo Amazon Nova Premier, recientemente introducido en AWS re:Invent de diciembre de 2024. Estos modelos están diseñados para proporcionar inteligencia de vanguardia con patrones de costo-efectividad líderes en sus categorías. La familia Nova incluye niveles desde Amazon Nova Micro, optimizado para despliegues en el borde, hasta Amazon Nova Premier, enfocado en tareas complejas.

Además, a través de la destilación de modelos en Amazon Bedrock, los clientes pueden transferir capacidades de inteligencia de Nova Premier a modelos más rápidos y rentables como Nova Pro o Nova Lite, adaptados a dominios específicos. Este proceso se accede mediante la consola de Amazon Bedrock y APIs como Converse e Invoke.

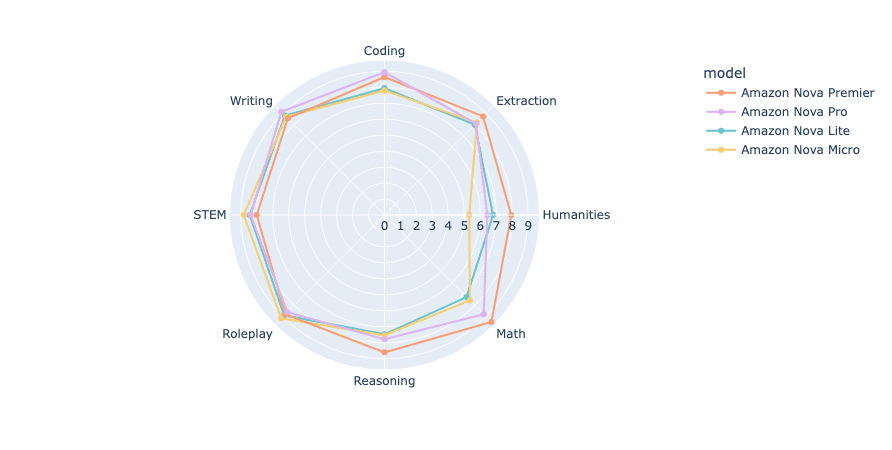

La evaluación realizada con MT-Bench y Arena-Hard revela una jerarquía clara de rendimiento entre los modelos Amazon Nova. En particular, Amazon Nova Premier logró el puntaje más alto, seguido de Nova Pro, mientras que Nova Lite y Nova Micro también demostraron resultados respetables. Un análisis de la eficacia de respuesta mostró que, a pesar de ser el modelo más grande, Nova Premier generó respuestas más concisas con eficiencia de token superior.

Por otro lado, Arena-Hard-Auto utiliza un conjunto de 500 indicaciones desafiantes para evaluar distintos LLM mediante comparaciones en pares, aplicando un modelo robusto para calcular el rendimiento en función de múltiples categorías de preferencias, permitiendo un análisis más profundo de las capacidades del modelo.

El estudio concluye que los modelos Amazon Nova ofrecen un rendimiento sólido en diversas tareas mientras mantienen bajos costos operativos, siendo una opción competitiva para empresas que buscan eficiencia sin comprometer la calidad. Esta investigación subraya la importancia de las metodologías de evaluación en la selección y despliegue de modelos en aplicaciones del mundo real.