La integración de AWS Batch con Amazon SageMaker está transformando la gestión de cargas de trabajo en equipos de aprendizaje automático. En el contexto actual de la inteligencia artificial generativa, muchas organizaciones enfrentan el desafío de esperar disponibilidad de unidades de procesamiento gráfico (GPU) para ejecutar sus modelos, lo que lleva a una pérdida de tiempo significativa en la coordinación de recursos en infraestructuras no siempre optimizadas.

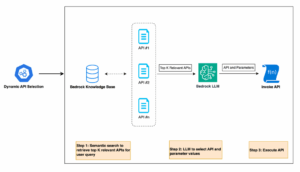

Una reciente innovación en este campo permite a los investigadores manejar colas de procesos, enviar y reintentar trabajos de entrenamiento de modelos sin complicaciones asociadas a la infraestructura. AWS Batch, ahora integrado con SageMaker, promete una programación inteligente de trabajos y gestión automatizada de recursos, liberando a los científicos de datos para que puedan enfocarse más en el desarrollo de modelos, en lugar de preocuparse por la coordinación de la infraestructura.

Esta integración fue especialmente valorada por el Toyota Research Institute, que ha experimentado una mayor flexibilidad y rapidez en sus procesos de entrenamiento. Gracias a las características de programación con prioridad de AWS Batch, los investigadores pudieron ajustar dinámicamente sus tuberías de entrenamiento. Esto permitió optimizar los recursos, priorizar trabajos críticos y alcanzar un equilibrio en la demanda entre diferentes equipos, logrando así un uso más eficiente de instancias aceleradas y reduciendo costos.

El funcionamiento de AWS Batch se basa en una gestión integral de las cargas de trabajo. Al enviar un trabajo, AWS Batch evalúa los requisitos de recursos, lo coloca en la cola adecuada y lanza las instancias necesarias, escalando automáticamente según la demanda. Además, ofrece mecanismos de reintento automático que reinician trabajos fallidos y programación equitativa, evitando que un solo proyecto monopolice los recursos.

Para las empresas que utilizan SageMaker, configurar AWS Batch para trabajos de entrenamiento podría parecer inicialmente complejo. No obstante, la plataforma proporciona guías claras para la creación de entornos de servicio y colas de trabajo, facilitando a los investigadores el envío de trabajos y la monitorización de su estado de manera intuitiva. Se recomienda que cada cola de trabajo se alinee con un entorno de servicio específico, optimizando así la eficiencia y el uso de recursos.

Este avance en la gestión de cargas de trabajo de aprendizaje automático se traducirá en un aumento de la productividad y reducción de costos operativos, asegurando un uso efectivo de los recursos y permitiendo que tanto científicos como administradores de infraestructura se concentren en sus áreas de expertise.