Amazon Bedrock ha lanzado recientemente una innovadora funcionalidad llamada Knowledge Bases, que promete revolucionar la forma en que se implementan los flujos de trabajo de Generación Aumentada por Recuperación (RAG). Esta nueva capacidad gestionada busca simplificar el complejo proceso de ingestión, recuperación y augmentación de prompts, sin la necesidad de construir integraciones personalizadas ni gestionar flujos de datos.

El ámbito de optimización del rendimiento de estas bases de conocimiento es bastante amplio y variado, con cada caso de uso viéndose afectado de manera particular por los diversos parámetros de configuración. Esto hace esencial la realización de pruebas constantes y el ajuste rápido de configuraciones para encontrar la mejor opción adaptada a cada situación específica.

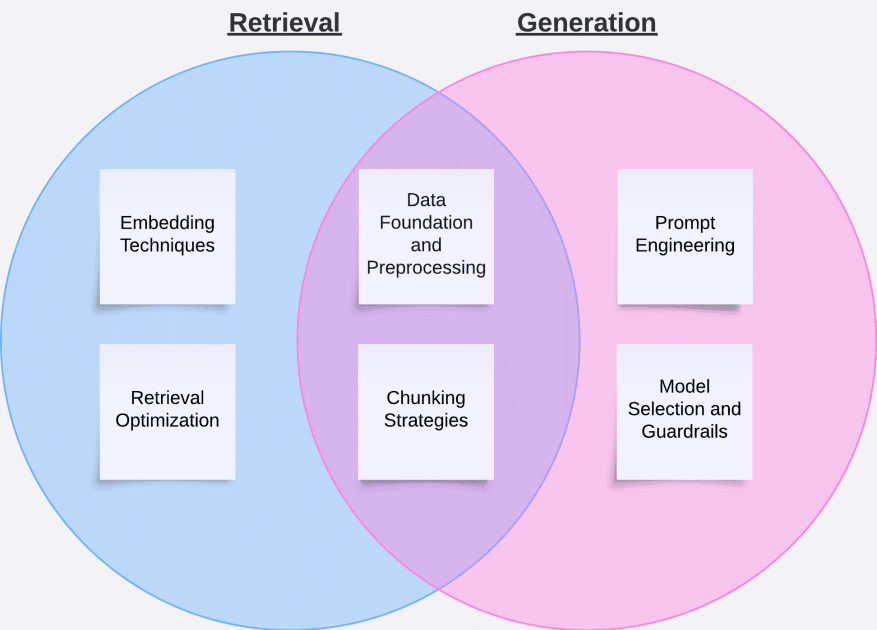

En un detallado artículo reciente, se describen las distintas etapas que permiten evaluar el rendimiento de una base de conocimiento. Estas comprenden tanto la evaluación del proceso de recuperación de información como de la generación de respuestas. La fase de recuperación se enfoca en obtener fragmentos relevantes de documentos en respuesta a una consulta específica y añadir este contenido como contexto al prompt final. Por su parte, la fase de generación implica enviar dicho prompt al modelo de lenguaje grande (LLM) y devolver su salida al usuario.

Para evaluar la fase de recuperación, se emplean dos métricas principales: la relevancia del contexto, que determina si la información recabada responde a la intención de la consulta, y la cobertura del contexto, que mide si los textos recuperados son exhaustivos en comparación con una verdad objetiva. Estas métricas se establecen al comparar los resultados de búsqueda con las respuestas esperadas dentro de un conjunto de datos de prueba estructurado específicamente para tales evaluaciones.

Una vez validada la eficiencia del flujo de trabajo de RAG en recuperar contexto relevante, es posible avanzar a la evaluación de generación. El marco de evaluación de Amazon Bedrock proporciona un análisis integral que contempla ocho métricas abarcando tanto la calidad de respuesta como aspectos de inteligencia artificial responsable. Las métricas de calidad de respuesta consideran la utilidad, corrección, coherencia lógica, completitud y fidelidad. En cuanto a la inteligencia artificial responsable, se evalúa la detección de contenido dañino, estereotipado y la respuesta adecuada a consultas inapropiadas.

Un conjunto de datos de prueba robusto es crucial para realizar una evaluación significativa. Se recomienda utilizar datos anotados humanamente, generación de datos sintéticos mediante LLMs y una estrategia de mejora continua basada en la retroalimentación de usuarios. Durante todo el proceso de optimización, es fundamental equilibrar las técnicas de mejora de rendimiento con un enfoque iterativo que permita realizar ajustes precisos y significativos.

En última instancia, la optimización de las Bases de Conocimiento de Amazon Bedrock es un proceso iterativo que requiere pruebas y ajustes sistemáticos. El éxito en este ámbito proviene del uso meticuloso de técnicas como la ingeniería de prompts y el chunking para perfeccionar tanto la recuperación como la generación. Monitorear las métricas clave durante este procedimiento asegura medir el impacto de las mejoras y garantiza el cumplimiento de los requisitos de la aplicación.