Las empresas están cada vez más interesadas en maximizar el potencial de los grandes modelos de lenguaje (LLMs) para resolver problemas prácticos. Sin embargo, conectar estos modelos con aplicaciones concretas ha sido un desafío significativo. Aquí es donde los agentes de inteligencia artificial entran en juego como una innovación crucial que promete cerrar esta brecha.

Amazon Bedrock se presenta como un motor fundamental para estos agentes de IA, proporcionando las capacidades necesarias para el razonamiento y la comprensión del lenguaje natural. Esto permite a los agentes interpretar solicitudes de usuarios y generar respuestas efectivas. Además, estos modelos pueden integrarse con diversas capas de orquestación y marcos de agentes para crear aplicaciones de inteligencia artificial que comprenden el contexto, toman decisiones y ejecutan acciones precisas.

Para los equipos que buscan automatizar y optimizar flujos de trabajo en GitHub, Amazon Q Developer presenta una solución integrada. Este servicio permite generar, revisar y transformar código sin necesidad de desarrollar agentes personalizados. La flexibilidad de Amazon Q Developer es ideal para flujos comunes, mientras que organizaciones con necesidades específicas pueden crear soluciones personalizadas utilizando Amazon Bedrock junto a marcos de agentes. Esto ofrece a los equipos la opción de elegir entre una solución estándar o un enfoque a medida.

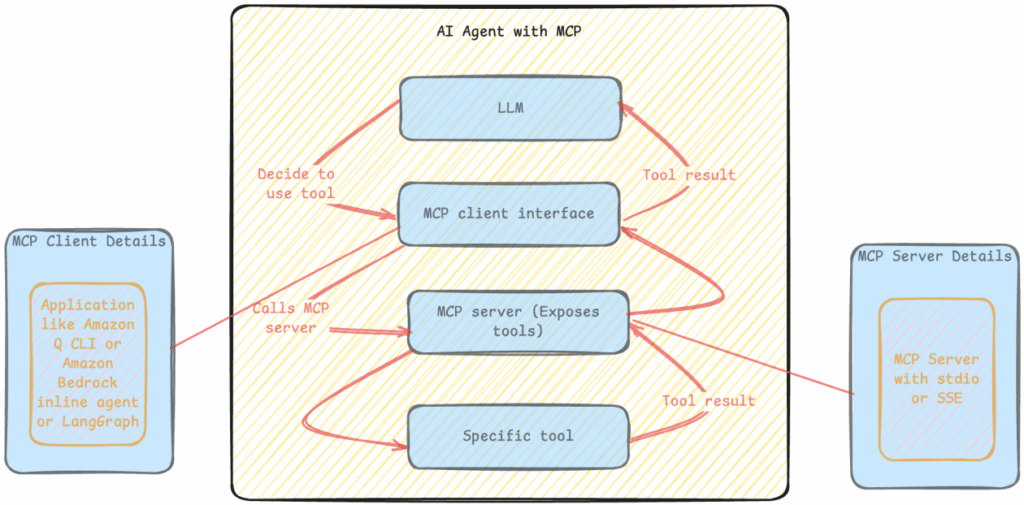

No obstante, la integración de agentes de IA enfrenta desafíos críticos. Uno de los principales es la falta de estandarización en la integración con herramientas externas. Aunque existen marcos como Amazon Bedrock Agents, LangGraph y el Strands Agent SDK, estos suelen requerir personalizaciones complejas. El Protocolo de Contexto del Modelo (MCP) emerge como una solución, proporcionando un marco estandarizado que redefine la interacción entre los modelos de base, la gestión del contexto y las herramientas.

El MCP simplifica la integración mediante un registro de herramientas y patrones de invocación estandarizados. Esto no solo reduce el esfuerzo de desarrollo, sino que también permite el uso de patrones más sofisticados, como encadenamientos de herramientas y llamadas paralelas.

La combinación de tecnologías avanzadas —los modelos de base de alta calidad de Amazon Bedrock, la gestión del contexto del MCP y el marco LangGraph— permite el desarrollo de agentes capaces de realizar tareas complejas con mayor eficacia. Imagina que tu equipo de desarrollo se encuentra con los problemas de GitHub ya resueltos y listos como solicitudes de extracción, gestionados de manera autónoma.

La evolución de los LLMs, especialmente aquellos con generación de código, ofrece un enfoque revolucionario para los flujos de trabajo de desarrollo. La utilización de agentes permite automatizar tareas comunes, como actualizaciones de dependencias o correcciones de errores, optimizando así el tiempo y los recursos de los desarrolladores.

Amazon Bedrock es un servicio gestionado que proporciona acceso a modelos de primer nivel de empresas líderes a través de una API unificada. Ofrece capacidades robustas para construir aplicaciones de IA generativa de forma segura y responsable. Por su parte, LangGraph estructura agentes a través de una arquitectura de grafos que maneja procesos complejos.

El MCP empodera a los desarrolladores al establecer conexiones seguras y eficientes con sus herramientas y fuentes de datos. Esto facilita la automatización de tareas, el análisis de código y la optimización de flujos de trabajo, mejorando así la eficiencia operativa.

La implementación de este sistema no solo busca incrementar la productividad, sino también transformar la forma en que trabajamos al abordar las limitaciones actuales de los agentes de IA. Con un enfoque en la colaboración entre la inteligencia artificial y los desarrolladores humanos, el futuro de la automatización en el desarrollo se vislumbra lleno de oportunidades si se gestionan adecuadamente los desafíos presentes.