Los sistemas de recomendación enfrentan un desafío significativo conocido como el «cold start», que se produce cuando no hay señales personalizadas al inicio para los nuevos usuarios o ítems. Esto significa que al llegar por primera vez o al presentarse contenido nuevo, no existe un historial de comportamiento que permita a los motores de recomendación identificar los intereses de los usuarios. Como consecuencia, todos son incluidos en amplios segmentos genéricos, lo que afecta negativamente las tasas de clics y conversiones y puede alejar a los usuarios antes de que el sistema pueda aprender sus preferencias. Las soluciones habituales, como el filtrado colaborativo o las listas de popularidad, no logran superar esta falta de señales personalizadas, haciendo que sus recomendaciones se vuelvan obsoletas rápidamente.

Sin embargo, se vislumbra un escenario diferente en el que se pueden generar perfiles detallados de interés desde el primer día. Utilizando modelos de lenguaje de gran escala, es posible crear ricas representaciones de usuario y artículo sin depender de semanas de datos de interacción, lo que transforma un inicio frío en una cálida bienvenida.

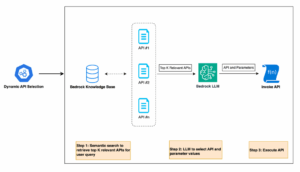

Con este fin, se ha desarrollado una solución que emplea los chips de Amazon EC2 Trainium, optimizando la implementación de modelos a través de contenedores de aprendizaje profundo con el AWS Neuron SDK. Este enfoque permite a los ingenieros de aprendizaje automático experimentar con diferentes configuraciones de modelos de lenguaje y encoders, logrando iteraciones rápidas en métricas de recomendación sin necesidad de modificar el código del modelo base.

En el desarrollo de esta solución, se utilizó el conjunto de datos de reseñas de libros de Amazon, que ofrece reseñas de usuarios reales y metadatos de miles de libros. Esto facilita la simulación de escenarios de «cold start», donde un nuevo usuario solo tiene una reseña para trabajar. Mediante un modelo de lenguaje, se enriquece el perfil del usuario desde datos limitados, infiriendo subtemas relacionados que podría disfrutar.

El siguiente paso consiste en convertir tanto los intereses expandidos como el catálogo de libros en vectores comparables mediante el uso de codificadores como Google T5. Se analiza cómo el tamaño de los codificadores afecta la calidad de las coincidencias, realizando búsquedas rápidas a través de índices FAISS.

La calidad de las recomendaciones se mide posteriormente, revelando que, al aumentar el tamaño de los modelos, las señales generadas son más discriminativas. Este análisis permite a los desarrolladores encontrar la combinación óptima de modelos y codificadores que ofrezcan un rendimiento factible sin incurrir en costos excesivos.

Finalmente, se espera implementar estos modelos en un entorno de producción, asegurando que los perfiles de usuario enriquecidos estén listos para conectarse con más contenido. Esta iniciativa demuestra cómo el uso adecuado de la tecnología de aprendizaje automático puede transformar los sistemas de recomendación, mejorando la experiencia del usuario desde el primer instante.