En una nueva entrega de la serie sobre personalización de modelos DeepSeek, se ha presentado un enfoque detallado para ajustar el modelo DeepSeek-R1 de 671 mil millones de parámetros, utilizando las recetas de Amazon SageMaker HyperPod. Tras el éxito de la fase inicial, este segundo artículo se centra en la implementación técnica necesaria para afinar el modelo, destacando las ventajas de su arquitectura «Mixture of Experts» (MoE).

El modelo DeepSeek-R1, desarrollado por DeepSeek AI, ha demostrado resultados prometedores en diversos benchmarks desde su lanzamiento. Con su entrenamiento basado en 14.8 billones de tokens, el modelo es capaz de realizar tareas de aprendizaje con pocas y ninguna muestra, adaptándose así a nuevos escenarios que no formaron parte de su formación inicial. La capacidad de personalización del modelo es particularmente valiosa para sectores como el financiero o el médico, permitiendo ajustes específicos con datos internos para maximizar su eficacia.

No obstante, personalizar modelos de gran escala requiere un cuidadoso equilibrio entre costos, requisitos de implementación y efectividad del rendimiento. En este contexto, las recetas de SageMaker HyperPod proporcionan un enfoque integral que combina entrenamiento distribuido, optimización y configuraciones avanzadas, facilitando su integración con los procesos de Amazon SageMaker.

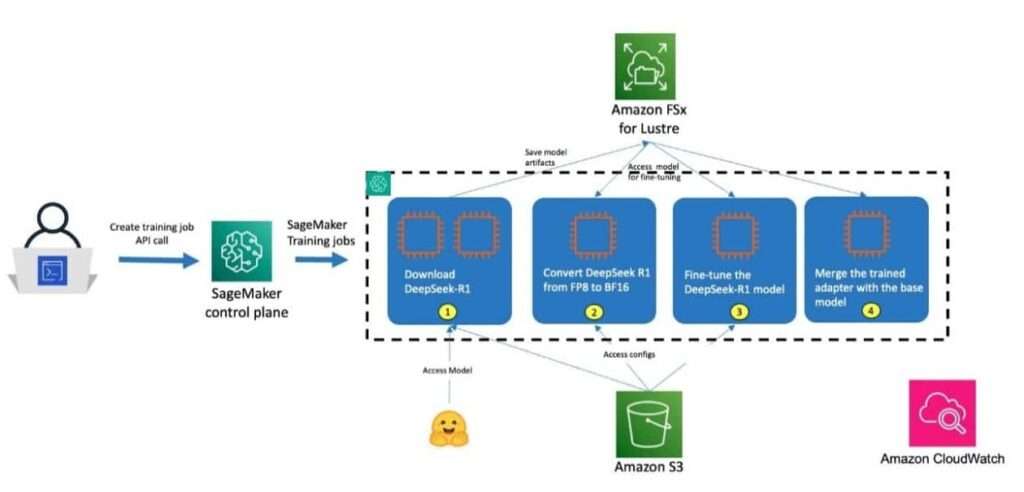

La arquitectura de la solución incluye un proceso detallado, explicando cómo los usuarios pueden comenzar la personalización desde el nodo de inicio del clúster Slurm hasta la implementación del modelo, utilizando Amazon FSx para Lustre para almacenar los puntos de control. El artículo describe cada etapa del proceso, desde la descarga del modelo hasta la conversión de pesos y la ejecución del ajuste fino con la técnica QLoRA (Quantized Low-Rank Adaptation).

Además, se proporcionan instrucciones sobre los requisitos previos y la configuración del entorno, asegurando que los profesionales en el campo puedan aplicar las técnicas descritas en sus sistemas de SageMaker.

En resumen, esta entrega no solo resalta la flexibilidad del modelo DeepSeek-R1, sino que también proporciona un marco claro para maximizar su eficiencia mediante personalización adaptada a las necesidades específicas de cada usuario. Se invita a los interesados a explorar el repositorio de recetas de SageMaker HyperPod en GitHub para acceder a documentación y ejemplos adicionales, reafirmando el compromiso de AWS en facilitar la formación efectiva de modelos de inteligencia artificial.