Con el creciente interés por los grandes modelos de lenguaje (LLMs) y las aplicaciones de inteligencia artificial generativa, la búsqueda de soluciones de inferencia más eficientes, escalables y de baja latencia se ha intensificado. Los sistemas de inferencia tradicionales, a menudo, enfrentan dificultades para satisfacer estas exigencias, especialmente en entornos distribuidos y multi-nodo. Para responder a estos desafíos, NVIDIA ha lanzado Dynamo, un marco de trabajo de inferencia de código abierto diseñado para maximizar el rendimiento y la escalabilidad de estas aplicaciones.

NVIDIA Dynamo es compatible con diversos servicios de AWS, incluyendo Amazon S3, Elastic Fabric Adapter (EFA) y Amazon Elastic Kubernetes Service (EKS). Además, puede implementarse en instancias de Amazon EC2 aceleradas por GPU, como las recientemente lanzadas P6, que operan con la arquitectura NVIDIA Blackwell.

Este marco de trabajo permite a los desarrolladores elegir entre diferentes componentes de servicio de inferencia, servidores API frontend y bibliotecas de transferencia de datos según sus necesidades específicas. Entre sus características principales, Dynamo destaca por separar las fases de prellenado y decodificación de los LLM, optimización dinámica de recursos de GPU y un enrutador inteligente que minimiza la recomputación de datos, mejorando así el rendimiento general.

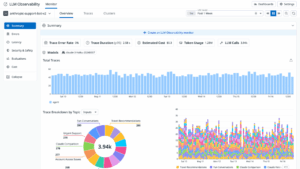

Una innovación clave de NVIDIA Dynamo es el «Planificador Dynamo», que gestiona los recursos de GPU de manera efectiva en entornos de inferencia dinámica. Este componente supervisa en tiempo real indicadores como las tasas de solicitud y las longitudes de secuencia, asignando los recursos necesarios de manera inteligente para asegurar un uso óptimo y adaptarse a los picos de demanda.

El «Enrutador Inteligente» de Dynamo también juega un papel crucial al facilitar la reutilización de la memoria caché de clave-valor (KV). Al dirigir las solicitudes hacia los trabajadores que ya tienen los datos necesarios, se logra una reducción del tiempo de inferencia y un uso más eficiente de los recursos de GPU.

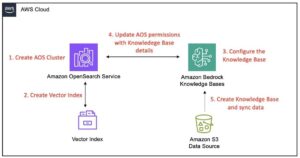

Además, el «Gestor de Bloques KV» de Dynamo aborda el desafío de almacenar grandes volúmenes de datos en la costosa memoria de alto ancho de banda de GPU, mediante un enfoque jerárquico que desplaza los bloques de caché menos solicitados hacia opciones de almacenamiento más económicas.

El marco incluye NIXL, una biblioteca de comunicación que optimiza la transferencia de datos a alta velocidad entre GPU, aspecto crítico para mantener un elevado rendimiento en implementaciones de IA distribuidas.

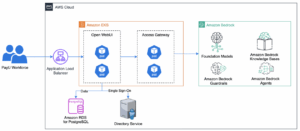

Amazon EKS se posiciona como una plataforma ideal para ejecutar cargas de trabajo de inferencia de LLM distribuidas, gracias a su sólida integración con otros servicios de AWS y sus características de rendimiento mejoradas. Con el soporte de Karpenter para escalado automático y EFA para conectividad de baja latencia, se simplifica la gestión de recursos necesarios.

A medida que las empresas continúan explorando las vastas posibilidades de la inteligencia artificial y los modelos de lenguaje, NVIDIA Dynamo emerge como una solución innovadora que une tecnología y eficiencia, permitiendo a las organizaciones maximizar sus inversiones en IA.