El avance de la inteligencia artificial generativa a escala global presenta desafíos notables, especialmente cuando se trata de evaluar la calidad de las respuestas en diversos idiomas. Muchas organizaciones enfrentan la dificultad de mantener un rendimiento uniforme, ya que las evaluaciones hechas por humanos requieren un gran número de recursos, principalmente cuando se trata de manejar múltiples lenguas. Este reto hace que las empresas se esfuercen por escalar sus procesos de evaluación sin comprometer la calidad ni afectar sus finanzas.

En este complejo panorama, Amazon Bedrock Evaluations emerge como una solución innovadora con su tecnología LLM-as-a-judge. Esta herramienta permite llevar a cabo evaluaciones consistentes de las salidas de IA a través de barreras lingüísticas, reduciendo así los recursos y el tiempo normalmente necesarios para evaluaciones multilingües, sin dejar de cumplir con altos estándares de calidad.

Amazon Bedrock ofrece la oportunidad de obtener resultados fiables sin tener que desarrollar infraestructuras localizadas o prompts específicos para cada idioma. A través de análisis exhaustivos, se propusieron estrategias que no solo reducen costos, sino también la complejidad de las evaluaciones.

El proceso simplificado por Amazon Bedrock Evaluations incluye métodos automáticos y humanos para juzgar la calidad de los modelos. Las evaluaciones automáticas permiten seleccionar métricas ya incorporadas o definir nuevas, fomentando así la evaluación de modelos tanto internos como externos. Por su parte, las evaluaciones humanas son esenciales para verificar la precisión de las puntuaciones automáticas, especialmente en contextos que requieren juicio experto.

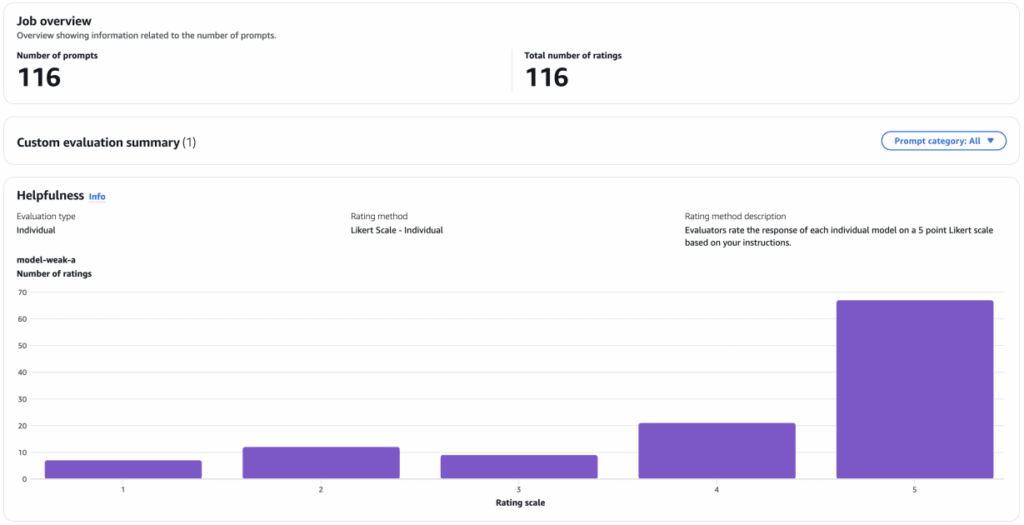

En las pruebas, se ha utilizado un conjunto de datos conversacionales en indonesio, transformando las interacciones multigeneracionales en turnos individuales que se evalúan de manera independiente. Esto ha permitido obtener registros evaluativos detallados, analizados mediante un contraste entre modelos robustos y débiles para generar respuestas.

La comparación entre puntuaciones proporcionadas por humanos y las otorgadas por LLMs mostró coincidencias significativas en modelos más fuertes, aunque en modelos más débiles, las puntuaciones de los LLMs eran más altas que las humanas.

El análisis también investigó la correlación entre las diversas puntuaciones, revelando un alineamiento sólido entre los jueces LLM y evaluadores humanos en modelos menos robustos, mientras que la concordancia disminuyó ligeramente en modelos más potentes.

En términos de evaluación multilingüe, se constató que la traducción de stimuli no es imperativa para obtener resultados coherentes. Los prompts en inglés proporcionaron evaluaciones efectivas para respuestas en otros lenguajes, facilitando así la extensión de evaluaciones de IA a nivel mundial.

Este estudio concluye que el método de LLM-as-a-judge es tanto práctico como eficiente, permitiendo evaluaciones rápidas y económicas, ideales para implementaciones de gran escala. La intervención humana sigue siendo crucial para establecer comparativas y asegurar que las evaluaciones automatizadas satisfagan las expectativas de los usuarios finales.